LA VIDEO NUMERIQUE

Aperçu des besoins et des techniques de codage et décodage

Ce texte est issu d'un article écrit en 2013. Certes ce n'est plus aujourd'hui à la pointe du progrès mais quelques-unes des notions développées restent d'actualité.

Vaste sujet d’actualité, pourquoi compresser et dans quel but ?

Dans le domaine de l’audiovisuel, qui nous intéresse plus particulièrement, depuis la "convergence" des années 90, l’image et le son n’ont pas échappé à la numérisation et à l’informatisation et sont devenus des suites de données numériques, des successions de “0” et de “1”.

Tiens, d’ailleurs, savez vous comment fait-on pour transformer un joli signal analogue, telle une image par exemple, en suite de “0” et de “1” ?

Réponse, avec un convertisseur AD qui transforme l’Analogue en Digital.

Des gens vous parleront de numérique et d'autre de digital, ne vous laissez pas abuser, Numérique et Digital ont la même signification.

Tant que l’image et le son étaient des signaux analogues, il n’était pas vraiment pensable de compresser, il a donc fallu attendre de passer dans un domaine digital pour pouvoir commencer à y songer.

Donc, maintenant que nous disposons de flux numérique, que fait-on ?

Avec l’avènement de la HD numérique, les informations décrivant une image animée sont devenues extrêmement nombreuses, ce qui nécessite un débit élevé ainsi que des capacités de stockage rapide et importantes, conditions qui ne sont pas toujours réunies, voire disponibles.

Ces conditions d'utilisation peuvent aussi être considérées comme trop onéreuses.

La meilleure méthode pour rester dans des limites raisonnables de quantité de données et de flux est d’appliquer une “réduction” au signal, acte courant aujourd’hui que nous appelons communément “compression”. Ce signal, une fois compressé, deviendra beaucoup moins encombrant, et pourra être plus facilement transporté et enregistré sur des appareils peu coûteux. Parallèlement, la diffusion en sera facilitée et s’opérera de manière moins “gloutonne” en bande passante.

Que peut-on réduire ?

Qu’est-il judicieux de réduire ?

Jusqu’où aller dans la réduction des données ?

Peut-on réellement abandonner certaines informations sans crainte ?

Comment faire pour reconstruire le signal original après compression ?

Est-ce qu’une compression sans perte, communément baptisée “lossless”, existe vraiment ?

Pour bien comprendre les choses, il faut faire un bref retour en arrière,... remarquez qu’un retour “en avant” eut été difficilement réalisable... et se pencher quelques instants sur l’histoire de la vidéo.

Penchons nous donc...

Dans une période pas si éloignée… il y a de cela à peine une trentaine d’années... la vidéo était analogique.

Dans une période pas si éloignée… il y a de cela à peine une trentaine d’années... la vidéo était analogique.

Eh oui, c’était ainsi !

Avant de devenir numérique, la vidéo a été analogique.

On m’a parfois demandé… mais alors, à cette époque, comment faisiez-vous ?

Eh bien, à cette époque, pour régler et optimiser un système vidéo analogique, nous disposions d’outils de précision qui étaient :

- le mètre à ruban,

- la pince coupante

- et la pince à sertir.

En plus de cela, chacun avait dans sa poche son petit “tweaker” pour ajuster, compenser, régler, et suivre en temps réel l’évolution des “choses”.

Quelques centimètres d'écart entre 2 câbles et vous aviez créé une nouvelle variété d'orange de couleur bleue ou des bananes vertes...

Finalement, ça ne fonctionnait pas si mal que ça, et tout le monde était motivé et fier de participer à cette grande aventure !

Les années 80 ont été les années du déploiement des technologies audio numériques et les années 90 ont été celles de la vidéo numérique.

En quelques années la numérisation de la vidéo a balayé les acquis analogiques, mis en œuvre de nouvelles méthodes de travail, ce que l’on appelle doctoralement “workflow”, a résolument révolutionné ce domaine et a malheureusement également participé à sa dérégulation totale.

Tout commence donc par la captation d’une image. A ce stade, un capteur photo sensible de type C MOS ou CCD transforme l’image en données électriques qui sont en relation directe avec le contenu de l’image.

Le convertisseur va transformer ces données électriques “analogiques” en données numériques.

C’est à partir de ce moment-là que les choses vont réellement commencer.

Afin de permettre des échanges faciles et une interopérabilité entre systèmes, il a fallu, dans un premier temps, se pencher sur les caractéristiques que l’on attendait d’un tel signal.

En 1982, la norme CCIR 601 décrit la composition d’une image numérique et la définition du flux numérique SDI de 270 MB. A cette époque, un flux de 270 Mb/s était considérable. Nos bons vieux “câbles verts”, qui étaient en charge d’acheminer de la vidéo analogique, encodée ou composante, se contentaient de transmettre des signaux ayant une bande passante globale de 6 MHz. Bien entendu, avec 270 MHz il a fallu développer de nouveaux câbles et toute une nouvelle technologie.

C’était un bond impressionnant. On passait carrément à la vitesse supérieure en multipliant le signal de base par un facteur 45 !

Dès 1983 un groupe d’étude est chargé d’étudier les répercussions des technologies numériques sur le signal Haute Définition.

Il faut dire que la Haute Définition ne date pas d’hier. De même que la vidéo standard, la Vidéo Haute Définition a été analogue avant de devenir numérique.

Pour faire simple, on peut assimiler la Haute Définition analogique des débuts à une usine à gaz.

Avec une bande passante luminance de 30 MHz, en analogue, les choses s’avéraient très compliquées dès l’origine.

On avait déjà du mal à enregistrer des signaux à 6 MHz, alors 30 MHz, vous pensez bien... C’est pourquoi la Haute Définition analogue des années 80 a été volontairement mise en veilleuse en attendant des technologies mieux adaptées.

Et c’est là en 1983, alors que l’on venait tout juste de définir une norme numérique SD, que quelques visionnaires se dirent que le numérique pourrait certainement apporter quelque chose à la HD.

L’avenir tendra à leur donner raison.

Ces travaux ont été concrétisés par la recommandation ITU 709 de 1990, qui décrit le signal HD numérique.

Les 3 points les plus importants de cette recommandation internationale sont :

- CIF – Common Image Format – Format d’Image Commun

- CDR – Common Data Rate – Flux Numérique Commun

- CSL – Common Sampling Lattice – Structure d’Echantillonnage Commun

En 1990 la norme ITU 709 permettait à la Haute Définition, en devenant numérique, de prendre réellement son essor. Mais la partie n’était pas encore gagnée pour autant. La HD numérique non compressée c’est un flux à 1, 485 GHz. C’est vraiment beaucoup !

Comme quelques années auparavant, mais cette fois dans le domaine numérique, on multipliait encore la bande passante de la SD par un facteur de 5,5.

Comment faire pour acheminer et diffuser de tels signaux ?

On avait déjà eu un problème similaire en SD quand il avait fallu diffuser des signaux à 270 MB/s dans des canaux de diffusion de 6 MHz.

La réponse avait été : Compression !

Indépendamment de l’opération commerciale et industrielle, la HD apportait une vraie valeur ajoutée en nous permettant d’échapper aux images sordides et mal définies de la SD.

Reconnaissons tout de même qu’une première étape qualitative avait été franchie avec l’apparition des écrans plats et la diffusion numériques de type TNT.

TNT – Télévision Numérique Terrestre (Hertzienne) à ne pas confondre avec le trinitrotoluène C6H2(NO2)3CH3, mélange particulièrement instable découvert en 1863 qui s’obtient par Nitration du Toluène.

Bref, il fallait bien que la HD trouve sa place dans le “paysage audiovisuel”.

Les canaux de diffusion n’étant pas éternellement extensibles, il a été décidé que la Haute Définition, emprunterait des canaux de diffusion de la “même taille” que les canaux SD.

On n’est donc d’accord sur le consensus d’une HD qui ne prend pas plus de place en diffusion que la définition standard.

C’est l’histoire du chameau et du chas de l’aiguille... tout le monde connait !

Le préalable était : faites en sorte que la HD à 1 485 MHz voyage dans des canaux de 6 MHz, voire moins, pour diffusion par la TNT et l’ADSL et on en reparlera.

Avec la SD on avait déjà exploré les voies de la compression, mais là, du fait de la quantité encore plus importante d’informations, on ouvrait en grand la porte du domaine de la compression. Et c’est comme ça que ça s’est passé !

La télévision transmet une image à distance par l’intermédiaire d’un signal vidéo comprenant des informations électriques qui caractérisent les images.

La télévision transmet une image à distance par l’intermédiaire d’un signal vidéo comprenant des informations électriques qui caractérisent les images. Le domaine de la vidéo, consiste à capter l’image, de la transformer en signaux électriques afin d’en permettre l’enregistrement, le transport et la reproduction.

Les différentes informations contenues dans l’image peuvent être acquises en parallèle ou en série.

Pour assurer une bonne transmissibilité, on s’est débrouillé pour mettre toutes les informations en série, à la queue leu leu, ce qui fait que l’on peut transmettre le signal vidéo par un câble unique …

La vidéo, comme le cinéma, fait appel à un défaut majeur de l’œil qui est la persistance rétinienne.

Si l’œil était aussi affuté que l’oreille l’est dans son domaine, on ne percevrait pas une image animée, mais une succession de lignes en mouvement se déplaçant du haut vers le bas de notre téléviseur.

Heureusement que l’œil est bourré de défaut sinon nous n’aurions jamais pu profiter de nos stars préférées au cinéma et sur le petit écran.

En vidéo, on va analyser l’image de la gauche vers la droite, ligne par ligne en allant du haut vers le bas.

Contrairement à la vidéo analogue, la vidéo numérique ne permet plus de voir directement un contenu d’image sur un oscilloscope car la ligne vidéo est composée d’une succession de données binaires qui, tout en étant directement représentatives du contenu, ne permet pas de le visualiser de manière analogue.

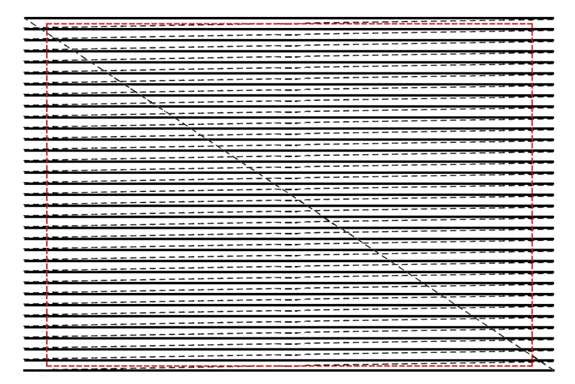

En mode vidéo entrelacé, l’image est constituée de 2 demies images que l’on appelle trames. Pour recomposer proprement l’image, il faut afficher les trames dans le bon ordre puisqu’il s’agit d’un affichage séquentiel qui se déroule dans le temps.

En mode vidéo entrelacé, l’image est constituée de 2 demies images que l’on appelle trames. Pour recomposer proprement l’image, il faut afficher les trames dans le bon ordre puisqu’il s’agit d’un affichage séquentiel qui se déroule dans le temps. Il faut donc afficher la première trame en premier, ça semble être une lapalissade mais c’est de première importance. Il y a une trame Impaire qui démarre en début de ligne et couvre toutes les lignes impaires 1, 3, 5, etc. Cette trame est affichée en premier, c’est la première trame.

Un cinquantième de seconde plus tard, du moins en Europe (un soixantième aux Etats Unis et au Japon), est affichée la deuxième trame que l’on a baptisée trame Paire du fait qu’elle couvre toutes les lignes paires de l’image, à savoir : 2, 4, 6, etc. Avec le décalage temporel entre les trames on obtient la cadence globale de 50 trames par seconde pour 25 images, ce qui évite le scintillement.

Vocabulaire.

Ne vous laissez pas abuser par les multiples noms donnés aux trames.

La Première Trame est la Trame Impaire, aussi appelée Trame Supérieure ou Odd field et Upper field en anglais.

La Deuxième Trame est la Trame Paire, aussi appelée Trame Inférieure ou Even field et Lower field en anglais.

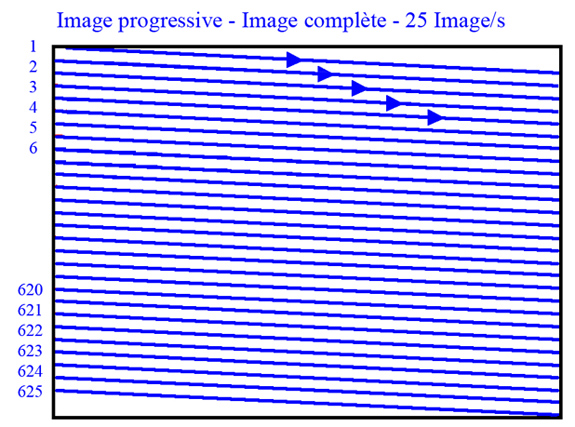

En progressif, il n’y a qu’une seule image complète à la cadence de 25 images par seconde (en Europe). Contrairement au mode entrelacé, en progressif, on dispose d’un cliché unique et complet tous les 25 eme de seconde au lieu de deux demis clichés séparés dans le temps par un intervalle d’un 50ème de seconde.

Image Progressive :

Aujourd’hui, quasiment tous les moniteurs et téléviseurs, sans oublier les écrans d’ordinateur, sont en mode progressif. Ce qui peut présenter des problèmes et des artéfacts lors de l’affichage d’images entrelacées.

Aujourd’hui, quasiment tous les moniteurs et téléviseurs, sans oublier les écrans d’ordinateur, sont en mode progressif. Ce qui peut présenter des problèmes et des artéfacts lors de l’affichage d’images entrelacées.

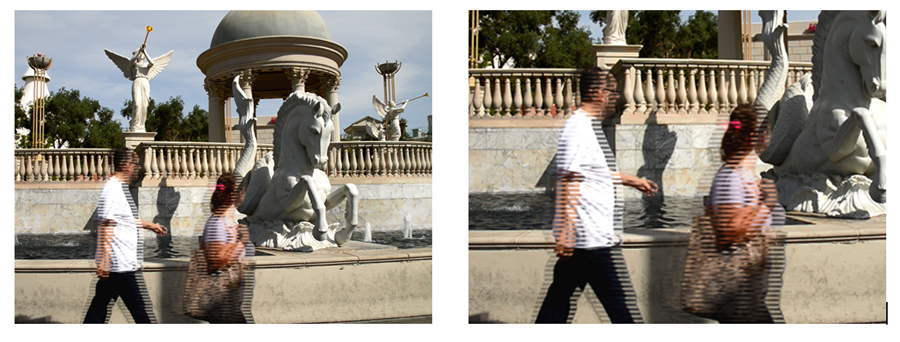

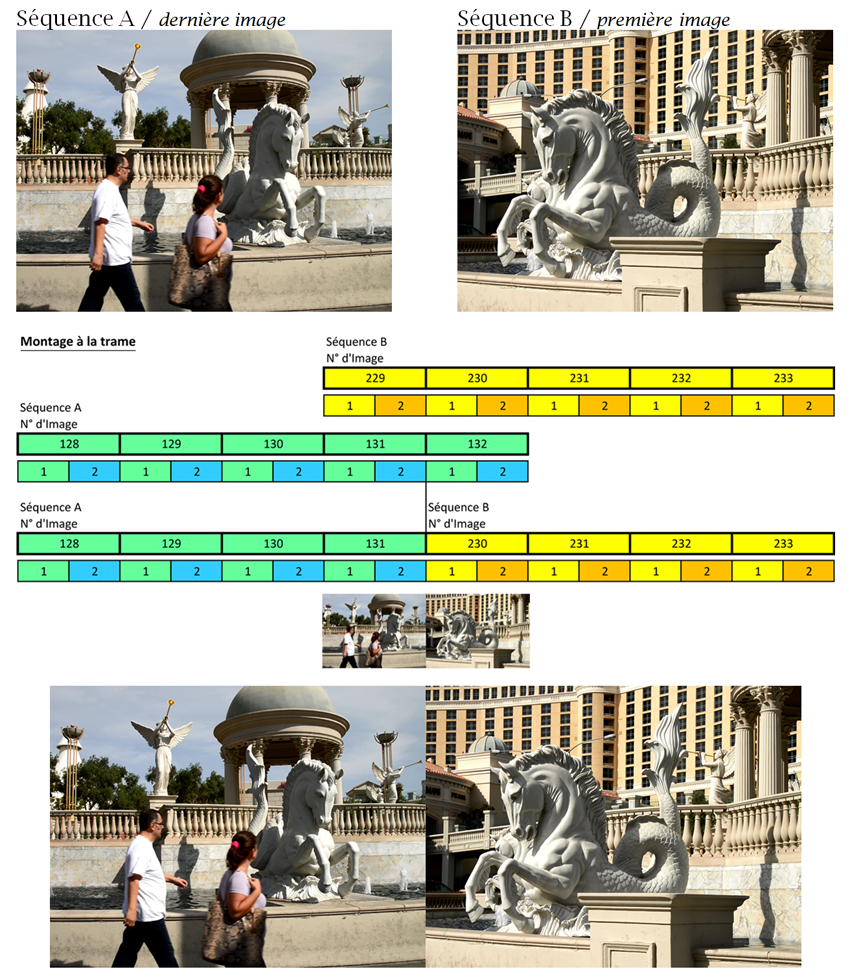

Dans la démonstration qui suit, les effets ont été amplifiés volontairement pour qu’ils soient aisément perceptibles.

Mode entrelacé :

Il y a un décalage perceptible entre les deux trames du fait des personnages en mouvement, ce qui n’est pas le cas du fond de l’image qui est immobile.

Si on superpose les 2 trames, on constate effectivement un décalage temporel dans le mouvement.

Si l’on affiche les 2 trames en même temps sans respecter le décalage temporel, on obtient une image dégradée qui combine les 2 trames en une seule unité de temps.

La deuxième trame “ayant fait du chemin” entre temps, si on la ramène au même niveau que la première trame, ça donne un résultat tordu mais pas surprenant.

C’est un artéfact bien connu des éléments en mouvement dans une image.

Pour éviter ce genre de problème, on peut désentrelacer l’image. C’est à dire reconstruire une image complète de 625 lignes qui s’affiche en 1/25ème de seconde au lieu des 2 trames affichées séquentiellement.

Ce n’est pas forcément si simple du fait du décalage temporel des 2 trames, les 2 trames n’ayant pas été exposées en même temps, mais séquentiellement.

La méthode la plus simple, la moins onéreuse et la plus sauvage aussi, consiste tout bêtement à abandonner une des deux trames et à doubler les lignes. Cette méthode ne préserve pas la qualité de l’image et entraine une demi-résolution verticale puisque l’on utilise finalement qu’une ligne sur 2.

Pour préserver la qualité, il faut travailler beaucoup plus finement et tenir compte du délai entre les 2 trames.

Indépendamment des diverses méthodes utilisées pour désentrelacer, on peut aussi avoir recours à un export en image fixe.

Dans ce scénario, les trames sont associées et un algorithme spécifique calcule la compensation nécessaire à appliquer pour contrecarrer le délai temporel des 2 trames.

Si vous prenez une séquence de une seconde, soit 50 trames entrelacées, et que vous l’exportez en TGA, par exemple, vous obtenez 25 images de super qualité.

Encore faut-il que les trames soient présenter dans le bon ordre, comme toujours.

Voici une image pleine résolution extraite d’une séquence d’une seconde de film par export TGA.

Comme on peut le voir, l’image est ici corrigée. Il y a eu un mélange “savant” des trames avec compensation temporelle pour préserver la qualité de l’image finale.

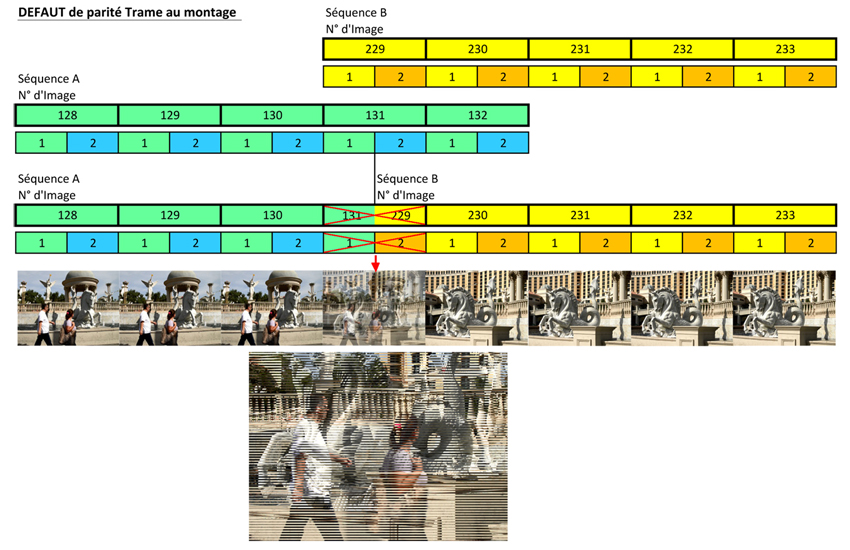

Un autre phénomène important de la parité des trames intervient lors du montage.

Un autre phénomène important de la parité des trames intervient lors du montage.

Lorsqu’on réalise un point de montage, on raccorde une image A avec une image B. En mode entrelacé, il est impératif de raccorder 2 images entières. Ce qui veut dire que l’on va raccorder les 2 trames A1 + A2 de l’Image A aux trames B1 + B2 de l’image B.

Si on respecte la parité trame le raccord entre les deux images sera correct :

En revanche si l’on ne respecte pas l’ordre des trames et si l’on mélange les trames des 2 images, on obtient une horreur au point de montage.

Cette image mélangée, pour le moins spéciale, est le résultat de la trame 1 de la dernière image de la séquence A et de la trame 2 de la première image de la séquence B. C’est donc une image qui n’existe pas et qui pollue.

Un codec, ayant pour vocation de réduire et de compresser les données de l’image, intervient, bien entendu, sur le contenu même de l’image.

S’il doit faire face à de mauvais arrangements de trames il aura un comportement désastreux et le résultat sera mauvais. Ce ne sera pas la faute du codec, mais du matériel qu’on lui a fourni !

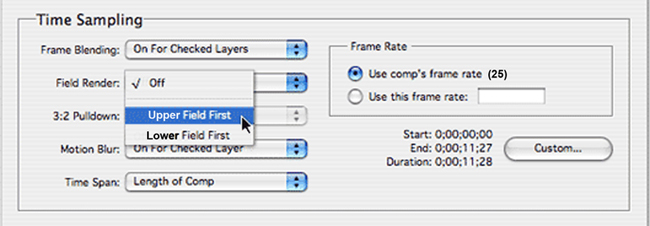

Avant tout encodage il faut donc bien vérifier ce que contient le fichier ou la cassette, une vidéo progressive, une vidéo entrelacée, si oui dans quel ordre afficher les trames. Car si on travaille sur un fichier entrelacé, le codec demandera à un moment ou un autre dans quel ordre présenter les trames.

Ce qu’il faut savoir : Tout ce qui est DV affiche la trame Paire (Inférieure) en premier alors que tous les autres formats et notamment les différents formats HD sont tous sur le mode trame Impaire (Supérieure) en premier.

En règle générale, la TV a gardé un comportement basique qui date de son origine en privilégiant le mode entrelacé. Même si les moniteurs et téléviseurs sont actuellement tous en mode progressif.

Si l’on y regarde bien, le mode entrelacé n’a pas que des désavantages, il permet artificiellement de réduire le scintillement et de fluidifier les mouvements, ce n’est donc pas totalement anodin.

En revanche, dès que l’on “tripote” un signal, il y a grand intérêt généralement à le désentrelacer.

En effet lors des calculs et des redimensionnements, les outils se comportent mieux s’ils traitent une image complète, progressive, qui est composée d’une seule “trame”.

C’est sans surprise !

Si l’on encode pour une visualisation sur ordinateur, il faut systématiquement désentrelacer le signal sinon les utilisateurs se trouveront face à des images de ce type et ça ne leur plaira pas vraiment !

Pour le reste, il est sage, quand on encode dans des formats qui sortent de l’ordinaire de désentrelacer. Dans les autres cas, si l’on part d’un signal entrelacé vidéo et qu’on utilise des codecs purement vidéo qui respectent l’intégrité du signal pour le traitement, DNX HD, PRO Res HQ et d’autres, on peut rester en entrelacé tout en faisant bien attention, lors de l’export final, de respecter la parité des trames, généralement en HD : Trame Impaire en premier.

Tous les codecs proposent, de manière accessible, un certain nombre de paramètres importants dont le choix de travailler en entrelacé ou en progressif et, dans le cas du mode entrelacé, le choix de l’ordre des trames.

bg-10/2013